Các nhà nghiên cứu tại Đại học Minnesota Twin Cities (Hoa Kỳ) đã phát triển một thiết bị phần cứng tiên tiến có thể giúp giảm đáng kể mức tiêu thụ năng lượng của các mô hình AI xuống ít nhất 1.000 lần.

GIẢI QUYẾT NHU CẦU NĂNG LƯỢNG CỦA AI

Với các ứng dụng AI ngày càng phổ biến, cả thế giới đang đứng trước nhu cầu cấp thiết phải nâng cao hiệu quả sử dụng năng lượng mà không ảnh hưởng đến hiệu suất hoặc chi phí leo thang.

Các quy trình AI truyền thống tiêu thụ một lượng lớn năng lượng bằng cách liên tục truyền dữ liệu giữa logic (xử lý) và bộ nhớ (lưu trữ).

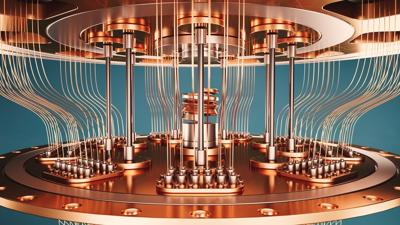

Mô hình mới của Đại học Minnesota, được gọi là bộ nhớ truy cập ngẫu nhiên tính toán (CRAM), giải quyết vấn đề này bằng cách giữ dữ liệu trong bộ nhớ để xử lý.

Yang Lv, một nhà nghiên cứu sau tiến sĩ tại Khoa Kỹ thuật Điện và Máy tính, tác giả chính của nghiên cứu, giải thích: “Công trình này là minh chứng thử nghiệm đầu tiên về CRAM, trong đó dữ liệu có thể được xử lý hoàn toàn trong mảng bộ nhớ mà không cần phải rời khỏi mạng lưới nơi máy tính lưu trữ thông tin”.

CRAM: NHÂN TỐ THAY ĐỔI CUỘC CHƠI VỀ HIỆU QUẢ SỬ DỤNG NĂNG LƯỢNG BẰNG AI

Cơ quan Năng lượng Quốc tế (IEA) dự đoán mức tiêu thụ năng lượng AI sẽ tăng gấp đôi từ 460 terawatt giờ (TWh) vào năm 2022 lên 1.000 TWh vào năm 2026, tương đương với tổng mức tiêu thụ điện của Nhật Bản.

Máy gia tốc suy luận học máy dựa trên CRAM có thể đạt được mức cải thiện năng lượng lên tới 1.000 lần, với một số ứng dụng cho thấy mức tiết kiệm năng lượng là 2.500 và 1.700 lần so với các phương pháp truyền thống.

Nhóm liên ngành, bao gồm các chuyên gia từ vật lý, khoa học vật liệu, khoa học máy tính và kỹ thuật, đã phát triển công nghệ này từ năm 2003.

Nghiên cứu này dựa trên công trình được cấp bằng sáng chế về Mối nối đường hầm từ tính (MTJ), các thiết bị có cấu trúc nano được sử dụng trong ổ cứng, cảm biến và các hệ thống vi điện tử khác, bao gồm Bộ nhớ truy cập ngẫu nhiên từ tính (MRAM).

CRAM tận dụng những tiến bộ này để thực hiện tính toán trực tiếp trong các ô nhớ, loại bỏ việc truyền dữ liệu chậm và tốn nhiều năng lượng điển hình của các kiến trúc truyền thống.

PHÁ VỠ NÚT CỔ CHAI VON NEUMANN

Hầu hết các hệ thống máy tính hiện đại đều được xây dựng trên cái được gọi là kiến trúc Von Neumann, trong đó các hệ thống logic và bộ nhớ con được tách biệt. Khi hoạt động, dữ liệu chuyển qua lại giữa các mô-đun bộ nhớ và bộ xử lý. Đây cũng là nền tảng vận hành cơ bản của máy tính ngày nay.

Kiến trúc CRAM khắc phục được nút cổ chai của kiến trúc von Neumann truyền thống, trong đó tính toán và bộ nhớ là những thực thể riêng biệt.

“CRAM rất linh hoạt”, Ulya Karpuzcu, Phó Giáo sư và chuyên gia về kiến trúc điện toán cho biết, “tính toán có thể được thực hiện ở bất kỳ vị trí nào trong mảng bộ nhớ”.

Tính linh hoạt này cho phép CRAM đáp ứng nhu cầu hiệu suất của các thuật toán AI khác nhau một cách hiệu quả hơn so với các hệ thống truyền thống.

CRAM sử dụng ít năng lượng hơn đáng kể so với các thiết bị bộ nhớ truy cập ngẫu nhiên (RAM) hiện tại dựa vào nhiều bóng bán dẫn để lưu trữ dữ liệu.

Nhóm của Đại học Minnesota hiện đang hợp tác với các nhà lãnh đạo ngành bán dẫn để mở rộng quy mô trình diễn và sản xuất phần cứng cần thiết nhằm giảm mức tiêu thụ năng lượng AI trên quy mô lớn hơn.

Sự phát triển của công nghệ CRAM thể hiện một bước tiến vượt bậc hướng tới điện toán AI bền vững. Chưa dừng lại, con số 1.000 lần mới chỉ là mức tối thiểu. Nhóm nghiên cứu đã thử nghiệm CRAM trên tác vụ phân loại chữ số viết tay MNIST và kết quả cho thấy nó "tiết kiệm năng lượng và thời gian lần lượt là 2.500 lần và 1.700 lần so với hệ thống xử lý gần bộ nhớ tại node công nghệ 16 nm".

Bằng cách giảm đáng kể mức tiêu thụ năng lượng AI trong khi vẫn duy trì hiệu suất cao, sự đổi mới này hứa hẹn sẽ đáp ứng nhu cầu ngày càng tăng của các ứng dụng AI và mở đường cho một tương lai hiệu quả hơn và thân thiện với môi trường hơn.

Google translate

Google translate