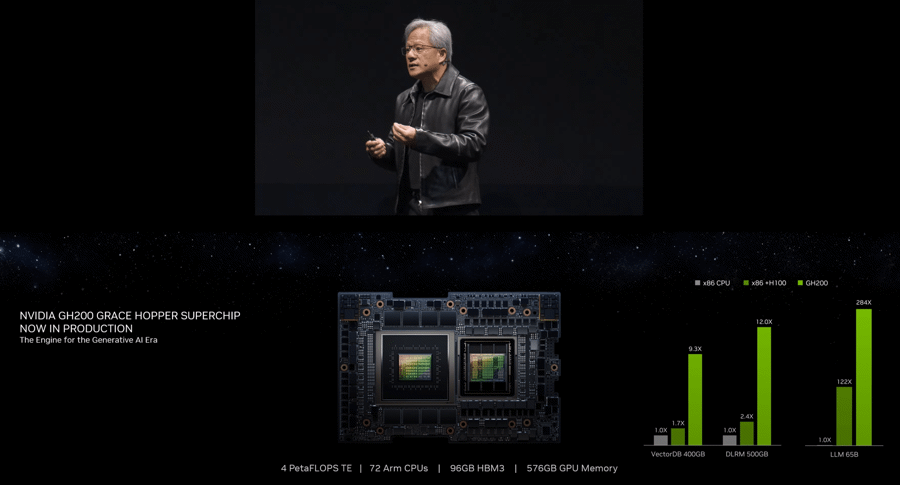

Trong bài phát biểu tại Computex, Jensen Huang – Nhà sáng lập và Giám đốc điều hành của Nvidia – đã thông báo rằng các hãng ASRock Rack, ASUS, GIGABYTE, Ingrasys, Inventec, Pegatron, QCT, Supermicro, Wistron và Wiwynn sẽ cung cấp các hệ thống AI đám mây, tại chỗ, nhúng và biên tận dụng GPU và kết nối mạng của Nvidia.

Ông Huang nhấn mạnh tầm quan trọng của quá trình chuyển đổi này: "Cuộc cách mạng công nghiệp tiếp theo đã bắt đầu. Các công ty và quốc gia đang hợp tác với Nvidia để chuyển các trung tâm dữ liệu truyền thống trị giá hàng nghìn tỷ USD sang tính toán tăng tốc và xây dựng một loại trung tâm dữ liệu mới– các nhà máy AI để sản xuất một mặt hàng mới: trí tuệ nhân tạo”.

CUNG CẤP HỆ THỐNG AI ĐA DẠNG

Các hệ thống được công bố phục vụ cho nhiều ứng dụng khác nhau, từ đơn GPU đến nhiều GPU, bộ xử lý x86 đến Grace và công nghệ làm mát bằng không khí đến bằng chất lỏng. Tính linh hoạt này đảm bảo rằng doanh nghiệp có thể chọn cấu hình tối ưu cho khối lượng công việc cụ thể của mình.

Nền tảng thiết kế tham chiếu mô-đun Nvidia MGX hiện hỗ trợ các sản phẩm Nvidia Blackwell, bao gồm cả nền tảng Nvidia GB200 NVL2 mới. Nền tảng này được thiết kế để mang lại hiệu suất vượt trội cho suy luận mô hình ngôn ngữ lớn chính thống, tăng cường truy xuất và xử lý dữ liệu. Với hiệu suất bộ nhớ băng thông cao từ các kết nối NVLink-C2C và công cụ giải nén chuyên dụng, tốc độ xử lý dữ liệu được tăng cường lên tới 18 lần, đồng thời tiết kiệm năng lượng tốt hơn 8 lần so với CPU x86.

KIẾN TRÚC THAM CHIẾU MÔ-ĐUN CHO TÍNH TOÁN TĂNG TỐC

Nvidia MGX cung cấp một kiến trúc tham chiếu cho phép các nhà sản xuất máy tính xây dựng nhanh chóng và tiết kiệm chi phí hơn 100 cấu hình thiết kế hệ thống. Cách tiếp cận này giúp cắt giảm chi phí phát triển tới ba phần tư và giảm thời gian phát triển xuống hai phần ba, chỉ còn sáu tháng. Hơn 90 hệ thống từ hơn 25 đối tác đã được phát hành hoặc đang trong quá trình phát triển, tận dụng kiến trúc tham chiếu MGX.

Cả AMD và Intel đều đang hỗ trợ kiến trúc MGX, có kế hoạch cung cấp các thiết kế mô-đun bộ xử lý máy chủ CPU của riêng họ, bao gồm nền tảng AMD Turin thế hệ tiếp theo và bộ xử lý Intel Xeon 6 với lõi P. Những thiết kế tham khảo này cho phép người xây dựng hệ thống máy chủ tiết kiệm thời gian phát triển trong khi vẫn đảm bảo tính nhất quán trong thiết kế và hiệu suất.

MỞ RỘNG HỆ SINH THÁI

Hệ sinh thái đối tác toàn diện của Nvidia bao gồm TSMC, nhà sản xuất chất bán dẫn hàng đầu thế giới, cùng với các nhà sản xuất điện tử toàn cầu như Amphenol, Asia Vital Components (AVC), Cooler Master, Colder Products Company (CPC), Danfoss, Delta Electronics và LITEON. Sự hợp tác này nhằm mục đích nhanh chóng phát triển và triển khai cơ sở hạ tầng trung tâm dữ liệu mới để đáp ứng nhu cầu của các doanh nghiệp trên toàn thế giới.

Các doanh nghiệp cũng có thể truy cập nền tảng phần mềm Nvidia AI Enterprise, bao gồm các dịch vụ vi mô suy luận Nvidia NIM. Nền tảng này cho phép tạo và vận hành các ứng dụng AI tạo ra cấp sản xuất.

Trong bài phát biểu quan trọng của mình, ông Huang nhấn mạnh việc áp dụng nhanh chóng công nghệ Blackwell của Đài Loan, Trung Quốc. Bệnh viện Chang Gung Memorial, trung tâm y tế hàng đầu của Đài Loan, Trung Quốc, có kế hoạch sử dụng nền tảng điện toán Nvidia Blackwell để thúc đẩy nghiên cứu y sinh và tăng cường các ứng dụng hình ảnh và ngôn ngữ, cuối cùng là cải thiện quy trình làm việc lâm sàng và chăm sóc bệnh nhân.

Foxconn, một trong những nhà sản xuất điện tử lớn nhất thế giới, dự định sử dụng Nvidia Grace Blackwell để phát triển nền tảng giải pháp thông minh cho nền tảng xe điện và robot hỗ trợ AI. Động thái này nhằm mục đích cung cấp nhiều trải nghiệm cá nhân hóa hơn cho khách hàng của mình thông qua ngày càng nhiều dịch vụ AI tổng hợp dựa trên ngôn ngữ.

Jonney Shih, Chủ tịch ASUS, nhấn mạnh sự hợp tác của họ: "ASUS đang hợp tác với Nvidia để đưa AI doanh nghiệp lên tầm cao mới với dòng máy chủ mạnh mẽ của chúng tôi mà chúng tôi sẽ trưng bày tại Computex. Sử dụng nền tảng MGX và Blackwell của Nvidia, chúng tôi có thể để tạo ra các giải pháp trung tâm dữ liệu phù hợp nhằm xử lý khối lượng công việc của khách hàng trong quá trình đào tạo, suy luận, phân tích dữ liệu và HPC".

TRIỂN VỌNG VÀ THÁCH THỨC TRONG TƯƠNG LAI CỦA NVIDIA

Trong buổi hỏi đáp báo chí, CEO Jensen Huang đã đề cập đến nhiều chủ đề khác nhau, bao gồm quan hệ đối tác, những tiến bộ về AI và tương lai của Nvidia. Trả lời câu hỏi về các đối tác bộ nhớ HBM, Huang nói rõ: "Chúng tôi làm việc với ba đối tác – SK Hynix, Micron và Samsung. Cả ba doanh nghiệp sẽ cung cấp cho chúng tôi bộ nhớ HBM. Chúng tôi đang cố gắng làm cho các sản phẩm này đủ tiêu chuẩn và được áp dụng vào sản xuất của chúng tôi càng nhanh càng tốt".

Thảo luận về sự cạnh tranh và tương lai của AI, ông Huang nhận xét: "AI là lực lượng công nghệ mạnh mẽ nhất trong thời đại chúng ta. Nó sẽ cách mạng hóa mọi ngành công nghiệp và Nvidia luôn đi đầu trong quá trình chuyển đổi này. Chúng tôi đang cung cấp các công cụ, nền tảng và hệ thống để thúc đẩy Đổi mới AI".

Các kế hoạch đầy tham vọng của Nvidia, được hỗ trợ bởi hệ sinh thái đối tác mạnh mẽ, đánh dấu sự thay đổi mang tính chuyển đổi trong ngành máy tính. Khi các doanh nghiệp nắm bắt các nhà máy điện toán và AI tăng tốc, kiến trúc Blackwell và nền tảng mô-đun MGX của Nvidia sẽ đóng một vai trò then chốt trong việc định hình tương lai của cơ sở hạ tầng trung tâm dữ liệu và AI tổng hợp.

Google translate

Google translate