SK Hynix và Samsung Electronics kiểm soát 90% thị trường toàn cầu về chip “bộ nhớ băng thông cao”. Những con chip này là thành phần quan trọng để phát triển các hệ thống trí tuệ nhân tạo (AI) chẳng hạn như ChatGPT của OpenAI.

Cả hai công ty Hàn Quốc đã công bố kế hoạch tăng gấp đôi sản lượng chip HBM của họ vào năm tới ngay cả khi họ thu hẹp quy mô ở những lĩnh vực khác, trong bối cảnh dư thừa nguồn cung đã làm giảm lợi nhuận hoạt động .

Daniel Kim, một nhà phân tích tại Macquarie cho biết: “Các chip HBM là một thành phần quan trọng đối với các máy chủ AI. Bạn không thể tạo ra các mô hình ngôn ngữ lớn mà không có chúng”.

NHU CẦU VỀ CHIP BỘ NHỚ AI TĂNG MẠNH

Tuần trước, Samsung đã công bố lợi nhuận hoạt động trong quý II là 668,5 tỷ Won (522 triệu USD), giảm 95% so với cùng kỳ năm ngoái. Tuy nhiên, công ty cũng báo cáo sự gia tăng đơn đặt hàng cho công nghệ bộ nhớ cao cấp bao gồm cả chip HBM3 thế hệ mới nhất.

Trước đó, SK Hynix, công ty đi tiên phong trong công nghệ này kể từ khi phát hành chip HBM đầu tiên trên thế giới vào năm 2015, đã thông báo về sự gia tăng nhu cầu liên quan đến AI ngay cả khi báo cáo khoản lỗ hoạt động 2,28 tỷ USD trong quý II năm nay.

Kim Woohyun, CFO của SK Hynix cho biết “Các máy chủ AI sử dụng bộ nhớ ít nhất gấp đôi đến tám lần so với các máy chủ truyền thống để xử lý tính toán nhanh hơn. Do đó, chúng tôi sử dụng các sản phẩm bộ nhớ hiệu suất cao như HBM. Điều này không chỉ thúc đẩy nhu cầu mà còn tác động tích cực đến lợi nhuận của công ty”.

Theo các nhà nghiên cứu tại TrendForce, SK Hynix chiếm 50% thị phần HBM toàn cầu vào năm ngoái, tiếp theo là Samsung với 40% và đối thủ của Mỹ là Micron với 10%.

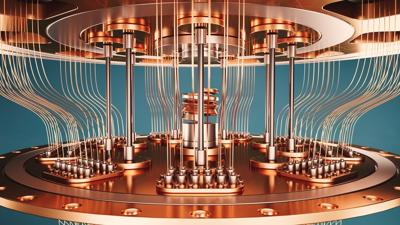

Ban đầu được sử dụng cho card đồ họa chơi game cao cấp, chip HBM vẫn chiếm một thị phần nhỏ trong thị trường “bộ nhớ truy cập ngẫu nhiên động” (Dram) toàn cầu. Họ sử dụng công nghệ xếp chồng để cải thiện băng thông và hiệu suất của các đơn vị xử lý đồ họa trong máy tính tốc độ cao.

Kim của Macquarie cho biết: “Về khối lượng, chip HBM sẽ chiếm khoảng 3% tổng số lô hàng Dram trong năm nay và 5% trong năm tới. Nhưng với mức giá cao, chúng sẽ chiếm 8-9% tổng doanh thu chip DRAM năm nay”.

NGUỒN CUNG HBM SẼ TRỞ NÊN KHAN HIẾM HƠN TRONG VÀI NĂM TỚI

SK Hynix năm ngoái đã trở thành công ty đầu tiên sản xuất hàng loạt chip HBM3 thế hệ thứ tư tiên tiến được sử dụng trong GPU H100 của Nvidia. Theo các chuyên gia trong ngành, nguồn cung HBM dự kiến sẽ tiếp tục khan hiếm trong hai năm tới do cần có thời gian để điều chỉnh công suất, trong khi việc tăng sản lượng HBM nhanh chóng là rất khó khăn do đòi hỏi dây chuyền sản xuất chuyên biệt.

Nvidia vẫn đang mua chip HBM dù giá tăng và đã đặt hết công suất để đáp ứng các đơn hàng GPU H100. Điều này góp phần gây ra sự thiếu hụt đối với những đối thủ nhỏ hơn.

Oh Jinwook, giám đốc công nghệ của công ty khởi nghiệp tăng tốc AI Hàn Quốc Rebellions cho biết: “Việc mua chip HBM3 trở nên khó khăn hơn khi các dịch vụ AI tổng hợp trở nên phổ biến hơn và Nvidia đang sử dụng hầu hết chúng cho GPU của mình”.

Theo nguồn tin thân cận, Nvidia và AMD cũng đã yêu cầu các mẫu chip HBM3E thế hệ tiếp theo của công ty Hàn Quốc, hiện những mẫu này chưa được sản xuất hàng loạt. Nvidia đã yêu cầu SK Hynix cung cấp HBM3E càng sớm càng tốt và công ty sẵn sàng trả “mức giá cao”.

“Chúng cần thiết cho GPU sử dụng ở các trung tâm dữ liệu và công việc đào tạo AI, vì vậy, cần phải mua chúng ngay cả khi giá đắt hơn” một đại lý tìm nguồn cung ứng chia sẻ Financial Times.

Samsung, nhà sản xuất chip duy nhất sản xuất hàng loạt chip HBM3, cũng đang nghiên cứu chip HBM3P thế hệ tiếp theo của riêng mình. Công ty dự kiến phát hành con chip này vào cuối năm nay.

Jaejune Kim, phó chủ tịch điều hành mảng kinh doanh bộ nhớ của Samsung, chia sẻ với các nhà phân tích rằng công ty sẽ tăng gấp đôi công suất HBM từ năm 2023 đến năm 2024. Samsung khẳng định rằng SamSung, chứ không phải SK Hynix, hiện đang dẫn đầu thị trường toàn cầu.

Trong khi đó, nhà sản xuất chip của Mỹ Micron đi sau các đối thủ Hàn Quốc ít nhất một thế hệ, theo các nhà phân tích. Tuy nhiên, tuần trước họ thông báo rằng họ đã bắt đầu lấy mẫu chip HBM3 Gen 2 nhằm thu hẹp khoảng cách với các công ty Hàn Quốc.

TrendForce dự kiến nhu cầu toàn cầu về chip HBM sẽ tăng 60% vào năm 2023 và 30% nữa vào năm tới. TrendForce dự đoán rằng đến năm 2024, SK Hynix sẽ chiếm 53% thị phần HBM, tiếp theo là Samsung với 38% và Micron với 9%.

Kim của Macquarie cho biết: “Đây là lần đầu tiên SK Hynix dẫn trước Samsung trong cuộc đua công nghệ bộ nhớ. SK Hynix đã sớm đặt cược vào chip HBM và đang gặt hái được thành quả”.

Google translate

Google translate