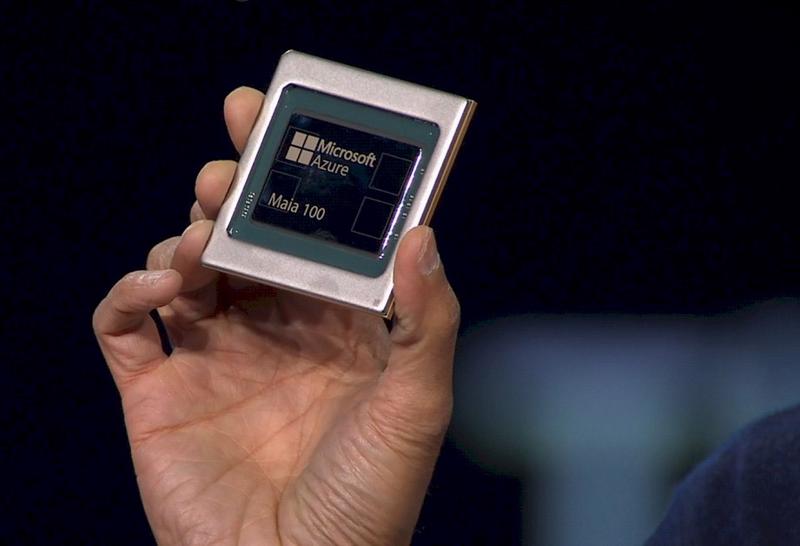

Trong sự kiện gần đây, Microsoft đã cho ra mắt hai loại chip AI nội bộ, nhằm mục đích tăng hiệu suất các sản phẩm AI như ChatGPT và giảm thiểu chi phí. Trong đó, chip AI Maia 100 được sử dụng để xử lý đồ họa AI, dùng trong các trung tâm dữ liệu, có thể cạnh tranh với chip do Nvidia sản xuất,. Với chip còn lại là Cobalt 100 Arm thì có những tác vụ tính toán, sử dụng trong các dịch vụ phần mềm dựa trên đám mây, nhằm cạnh tranh với bộ vi xử lý của Intel.

Việc gia công hàng loạt loại chip trên sẽ được thực hiện bởi công ty sản xuất chip Đài Loan, nhà sản xuất chip theo hợp đồng lớn nhất thế giới. Theo như chia sẻ của bà Rani Borkar, Phó Chủ tịch công ty trong một buổi phỏng vấn với CNBC, phiên bản máy ảo chạy trên chip Cobalt sẽ có sẵn trên thị trường thông qua đám mây Azure của Microsoft vào năm 2024. Tuy nhiên thời gian cụ thể phát hành chip Maia 100 vẫn chưa được thông báo.

Hiện nay, việc áp dụng bộ xử lý Cobalt đang tiến hành nhanh hơn so với việc thử nghiệm chip AI Maia 100. Gã khổng lồ công nghệ này đã cho chạy thử ứng dụng Teams và dịch vụ cơ sở dữ liệu Azure SQL trên bộ chip mới. Và cho đến nay, chúng đã hoạt động tốt hơn cỡ 40% so với chip dựa trên Arm hiện có của Azure đến từ công ty khởi nghiệp Ampere.

Microsoft đang thử nghiệm cách Maia 100 đáp ứng nhu cầu của chatbot AI của công cụ tìm kiếm Bing (hiện được gọi là Copilot thay vì Bing Chat), trợ lý mã hóa GitHub Copilot và GPT-3.5-Turbo, một mô hình ngôn ngữ lớn từ OpenAI do Microsoft hậu thuẫn. OpenAI đã cung cấp cho các mô hình ngôn ngữ của mình một lượng lớn thông tin từ internet và chúng có thể tạo email, tóm tắt tài liệu và trả lời các câu hỏi bằng một vài lời hướng dẫn của con người.

Ngoài việc thiết kế chip Maia, Microsoft còn phát minh ra phần cứng làm mát bằng chất lỏng tùy chỉnh có tên Sidekicks, đặt vừa trong các giá đỡ ngay cạnh các giá đỡ chứa máy chủ Maia.

Với GPU, việc tận dụng tối đa không gian hạn chế của trung tâm dữ liệu có thể đặt ra nhiều thách thức. Steve Tuck, đồng sáng lập và CEO của công ty khởi nghiệp máy chủ Oxide Computer, cho biết: Các công ty đôi khi đặt một vài máy chủ chứa GPU ở dưới cùng của giá đỡ để tránh tình trạng quá nóng, thay vì chất đầy giá từ trên xuống dưới.

Các công ty công nghệ giàu tiền mặt đã bắt đầu cung cấp cho khách hàng của họ nhiều lựa chọn hơn về cơ sở hạ tầng đám mây mà họ có thể sử dụng để chạy các ứng dụng. Việc sản xuất phần cứng AI nội bộ cho phép các công ty tăng hiệu quả xử lý dữ liệu và khả năng cạnh tranh của các dịch vụ như chatbot và phần mềm xử lý hình ảnh.

Nvidia có trụ sở tại Mỹ nắm giữ khoảng 80% thị trường chip AI. Nhu cầu đã tăng vọt cùng với sự bùng nổ của AI, với những con chip tiên tiến đôi khi được bán với giá từ 30.000 đến 40.000 USD. Đã có khoảng 10.000 con chip được cho là đã được sử dụng để phát triển ChatGPT, khiến chi phí của chúng trở thành gánh nặng đáng kể đối với các công ty AI.

Microsoft trước đây từng tham gia phát triển chip bán dẫn, chủ yếu dành cho máy chơi game và thực tế tăng cường. Nhưng phải đến động thái gần đây nhất mới thể hiện rõ sự thâm nhập toàn diện vào lĩnh vực này của gã khổng lồ, kết hợp các chip nội bộ vào cơ sở hạ tầng đóng vai trò là xương sống của phần mềm kinh doanh của họ.

Microsoft có liên minh kinh doanh và vốn với nhà phát triển OpenAI tại Mỹ của Chat GPT, cho phép công ty này cung cấp công nghệ AI của công ty khởi nghiệp cho các công ty và khách hàng khác thông qua đám mây và kết hợp AI vào công cụ tìm kiếm Bing của mình.

Hầu hết các dịch vụ AI đều dựa trên máy chủ của trung tâm dữ liệu. Bằng cách sử dụng các chip nội bộ chuyên dụng cho AI tổng quát trong các trung tâm dữ liệu của mình, Microsoft đặt mục tiêu vừa cải thiện hiệu suất vừa giảm chi phí mua sắm và vận hành.

Truyền thông Mỹ đưa tin, việc sử dụng chip nội bộ có thể giảm 1/3 chi phí vận hành các dịch vụ AI.

Tại sự kiện Ignite mới đây, Microsoft cũng đã công bố giới thiệu các chức năng AI cho phần mềm kinh doanh 365 của mình và sự hợp tác mới với các công ty chip lớn như Advanced Micro Devices và Nvidia.

Công ty cũng thông báo triển khai AI GPT-4 Turbo mới nhất của OpenAI, có thể xử lý các lời nhắc dài hơn.

Google translate

Google translate